刚满周岁,“未来之芯”IC PARK 年产值已突破240亿元5G与AI的齐头并进,使得中国集成电路在制造、封测、设计领域迎来了前所未有的发展机遇。

5G芯片市场上演了一出“强强争霸”的大戏。

2019年的12月5日,高通推出了全新处理器“骁龙865”和“骁龙765/765G”。就在同一天,华为发布已经搭载了麒麟990芯片的最新款5G手机nova6。再早些时候,联发科举行5G方案发布会,在中国正式推出“天玑1000”,三星Exynos 980也于2019年9月问世。一场5G二代芯片的竞技正式拉开帷幕。

5G芯片行业鏖战未消,AI技术也开始走向商业化阶段,中国芯片产业正处在一个高速发展的时期。各方面利好不断,以中关村集成电路设计园(IC PARK)为代表的各地集成电路产业园区也日渐成熟,让业界对芯片产业的未来十分看好。

IC和AI正在引发一场深刻变革

被誉为现代工业“粮食”的芯片,一定程度上也被视为国家科技创新能力的体现。直到最近几年,以华为、中兴为首的中国科技企业才开始崭露头角。

“5G是三十年一遇的大变化,很多产业和模式将被颠覆。”中国移动前董事长王建宙曾在公开场合这样表示。从诺基亚,到摩托罗拉,无数事实证明,每一代通信技术的更迭,都伴随着手机品牌和芯片厂商的洗牌。

行业从来不缺乏掉队者,受制于技术与市场等诸多因素,目前全球能够参与5G芯片竞争的也只有高通、三星、华为、联发科以及展锐。

行业也从不缺乏后继者,国内一国产手机厂商负责人曾表示:“如果想要做更好的产品,芯片自研是一条必经之路,虽然投资巨大,但在行业内,逐渐成为共识。”目前,包括苹果、三星、华为、小米、OPPO和vivo在内的手机厂商都在芯片层面或早或晚开始了投资。

“新陈代谢”正在行业的各个层面悄无声息地进行着,在市场巨大潜力的推动下,谁都有可能成为下一个科技巨头。

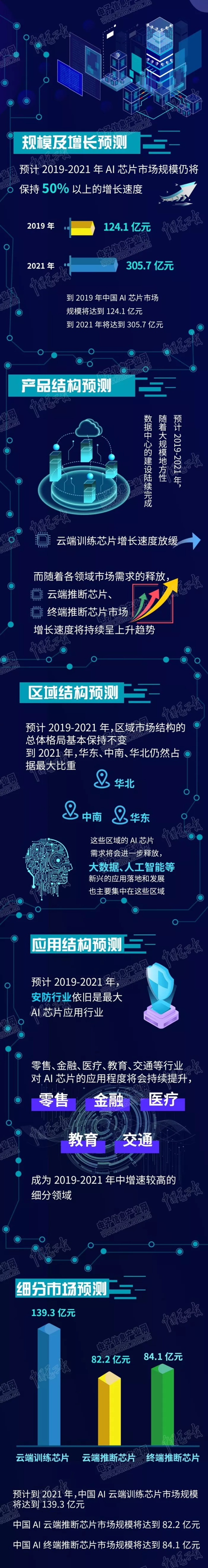

在5G芯片行业之外,一场人工智能的变革也正在酝酿着。经过几年的发酵,中国的AI技术已经取得了巨大的进步。

技术的进步带来市场的增长,到2020年我国人工智能产业规模有望突破1600亿元,带动相关产业突破1万亿元。

5G与AI的齐头并进,使得中国集成电路的技术和市场均保持良好的发展态势。IC PARK也给自己定下了“打造世界一流的集成电路设计产业园区”的目标,进一步优化营商环境,提高园区综合服务能力,增强对高端企业和项目吸引力。

理性投资,全面发展

在前不久的一场智能大会上,李开复如此说到:“AI行业正在回归理性,这是一个退潮知道谁在裸泳的时刻,需要回归商业本质。”他透露,AI作为最火的投资领域,曾有过许多不理性的投资,导致一些企业被过高估值。而到了2019年,上市则成为了他们无法越过的大山。

但回归理性,并不意味着市场冷却,事实上,更多的优质融投资正在改变AI行业的现状。

AI行业白皮书显示,2019年,产业资本和企业投资正在快速跟进。同时,AI技术与传统行业进一步产生了实质性融合,得益于聊天机器人和智能对话终端应用的大规模落地,企业级、消费级对话式人工智能平台市场驱动了整个人工智能软件市场的发展。

资金实力强劲的互联网巨头也加强了AI产业的战略布局。阿里巴巴重点布局安防和基础组件,投资了商汤、旷视和寒武纪科技等;腾讯投资的重点主要集中在智慧健康、教育、智慧汽车等领域,代表性的公司包括蔚来汽车、碳云智慧等企业;百度投资的重点主要在汽车、零售和智慧家居等领域。

一场关乎未来的投资之战正在上演,而这也表明,我国人工智能已进入商业化阶段。

行业的跨越性发展,使得市场对人才的需求剧增。根据《中国集成电路产业人才白皮书(2018-2019年版)》,到2020年前后,我国集成电路行业人才需求规模约为72万人左右,而我国现有人才存量46万人,人才缺口将达到26万人。城市之间,围绕着人才的争夺未曾停歇,各地纷纷出台人才政策,一个个激励IC创新研发的项目也在高校落地。

在区域产业聚集方面,中国集成电路已经形成上海为中心的长三角、北京为中心的环渤海、深圳为中心的泛珠三角以及武汉、西安、成都为代表的中西部四个各具特色的产业集聚区;北京、上海、合肥等数十个城市已建或者准备建设集成电路产业园。

IC PARK位于北京市海淀区,是一所建筑面积近22万平方米的IC设计产业园,正在以超越行业整体发展的速度,成为全国领先的园区范本,也为行业提供了诸多值得借鉴的经验。

被点赞的IC PARK ,如何做到了行业领先

好的园区要有头部企业,产生聚集效应;要有优秀设计人才,打造人才聚集高地;要有政策支持,扶持引导战略性产业发展;要有贴心服务,培养优秀的运营服务团队,用好公共科技创新服务平台。

政策、企业、人才、服务四个方面,也正是IC PAKR的优势所在。

经济学家马光远曾表示:“在下一个十年,海淀最有前景的地方就是海淀北部新区,北京科技创新的新增长点以及中关村未来的新发展就在海淀北部新区。”

依托于海淀北部新区的IC PARK,是北京“三城一区”的发展战略中,中关村科学城的核心之一,享受首都扶持创新产业和引进创新人才的政策优惠,入驻园区的企业在税收方面,可以两年免征,三至五年按25%的法定税率减半征收企业所得税。

不仅如此,这里还汇聚了清华大学、北京大学、中国人民大学等一批高精尖科研院校,是中国人才最扎堆的区域。

ICPARK董事长苗军曾总结到:“IC PARK最大的优势其实也是北京的优势,那就是人才、技术、项目、资本密集。”

在园区的服务上,IC PARK构建了“一平台三节点”产业服务体系。一平台指线上线下相结合的一站式企业服务平台,构建面向企业全生命周期的全方位、全过程服务价值链,其中的“三个节点”指的是投融资节点、孵化节点和人才节点。

近日,IC PARK主导的集成电路产业基金——芯创基金正式成立。这标志IC PARK以芯创基金为主导,“科技金融+认股权池+基金投资”的全生命周期的投融资体系已经形成。IC PARK成立的认股权池,与进驻园区企业签署认股权协议,在企业的增资扩股中,园区享有认股权,助力企业发展。

据了解,芯创基金总投资规模达15亿元,重点关注5G、云计算、汽车电子和AIOT等领域的投资。在2019年,芯创基金接收企业商业计划书300余个,调研对接企业150余家,储备项目40余个,立项5个,实现当年成立当年投资。2020年还将持续聚焦集成电路行业,预计投资额1.2亿左右。

在孵化方面,为了扶持中小型、创业公司的发展,IC PARK设立了3000平米孵化器“芯创空间”,以供小型的IC设计企业在园区进行独立研发或与园区内的大公司展开合作,还配有导师团队辅导创业者。

在人才方面,IC PARK联合七所在京示范性微电子学院和北京半导体行业协会、赛迪智库、中关村芯园、安博教育、摩尔精英共同发起成立中关村芯学院,园区与龙头企业共同发起成立人才产业化联盟,充分利用海淀区的人才资源,搭建起高校与企业人才培养和成果转化的桥梁,通过培养集成电路领域的复合型人才,助力“芯火”双创平台的建设与实施,缓解集成电路人才痛点问题。

芯片产业最关键的是产业链建设,在这方面,以龙头企业为引领、中小微创企业为补充,吸引了比特大陆、兆易创新、兆芯等数十家头部企业进驻,汇聚芯片企业50多家,产业组织模式日益成熟,产业配套也日益完善。

向来重视文化、生活配套的IC PARK,还在载体空间以及服务手段上进行了革新与创造。园区内配置了北京市唯一一家2000平方米的专业集成电路科技馆、建筑面积4200平方米的配套图书馆、2400平方米的IC国际会议中心,以及能够满足IC精英品质生活需求的两万平米的商业街区……足不出园,入驻人员的大部分商务、生活、交流需求都可以被满足。不设围墙的开放式空间布局,也惠及周边企业和居民。

如今,开园刚满周年的IC PARK,IC设计企业的年产值已经达到240亿元,占据全市集成电路设计领域产值的42%,创造税收40亿元,企业研发投入5亿元,专利数也达到了6068项,成为了一颗“未来之芯”。